Accueil > Médecine 2.0 > Le Web 2.0 pour les 2.nuls

Le Web 2.0 pour les 2.nuls

Première publication : samedi 24 novembre 2007,

par - Visites : 29337

Cet article cherche à expliquer ce qu’est réellement la transition 2.0. Employé pour tout et n’importe quoi, le concept 2.0 est à la mode, ce qui pourrait faire croire à tort qu’il n’est qu’une mode. Les articles qui le décrivent sont souvent remplis de mots compliqués (folksonomie, réseautique, paradigmes...).

J’ai essayé ici de rendre ce concept compréhensible au plus grand nombre.

La première chose à savoir, c’est que le Web 2.0 n’est pas nouveau. C’est une nouvelle étiquette collée récemment sur des choses anciennes. Mais comme beaucoup de nouveaux sites se réclament de ce concept, autant savoir de quoi l’on parle.

Vous ne savez pas ce que c’est que le Web 2.0 ? C’est normal, vous n’êtes pas le seul. Celui qui a inventé ce concept, Tim O’Reilly, en donne une définition assez complexe qui risque de ne pas beaucoup vous aider.

Et pourtant, même si vous ne connaissez pas grand-chose au fonctionnement d’internet, vous devriez comprendre de quoi il s’agit.

Le Web 2.0, c’est fondamentalement la version moderne de la devise des mousquetaires : Un pour tous, tous pour un.

On parle donc d’intelligence communautaire pour décrire les outils ou services "Web 2.0".

Le Web 2.0 transforme un groupe humain connecté en un cerveau virtuel

Nous allons voir que le cerveau humain est le meilleur modèle d’organisation pour comprendre le Web 2.0 : chacun de nos neurones n’a que peu d’intelligence propre, mais la richesse des connexions entre nos millions de neurones aboutit à un système complexe et intelligent qui caractérise l’humain.

Dans le Web 2.0, c’est nous qui sommes les neurones, plus ou moins connectés avec les autres, plus ou moins instruits, plus ou moins rapides pour transmettre l’information/l’influx nerveux. Le Web 2.0 nous fédère en un cerveau global car il permet les connexions nécessaires entre nos cerveaux mieux que ne l’a jamais fait aucun outil de communication.

Ce qui est nouveau n’est pas l’information ou la connaissance, mais la façon dont la parcelle que nous possédons chacun est connectée avec celle des autres humains.

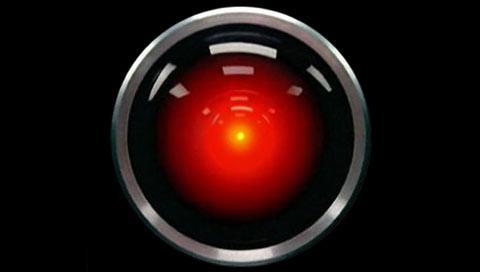

Ce metacerveau peut faire peur... ou faire rêver !

Faire peur car il touche à nos fantasmes de supermachine qui domine les humains, tel l’ordinateur HAL 9000 du film l’odyssée de l’espace. C’est un thème de science-fiction récurrent.

Il peut aussi faire rêver d’un monde atteignant un niveau supérieur de culture et d’intelligence.

Mais revenons sur terre ;-) et abordons des choses concrètes.

Le plus simple est d’étudier un service Web 2.0 qui fonctionne déjà sur ce principe d’intelligence collective

Rien ne vaut un exemple et un dessin pour comprendre.

L’un des premiers services Web 2.0 : Google !

Et oui, tel M. Jourdain, vous faisiez du Web 2.0 sans le savoir depuis des années ! Google trouvetout n’a pas toujours existé, il y a eu un "avant Google" que certains d’entre vous ont connu.

Aux débuts du Web, pour trouver les bonnes pages sur un sujet précis, les internautes continuaient à faire comme faisaient leurs ancêtres.

Comme les livres dans les bibliothèques, les sites étaient classés par catégories, par genre, type, sous-type etc. Bref, ce que l’on faisait depuis l’invention des documents écrits, soigneusement rangés dans des étagères par des bibliothécaires [1]. A l’intérieur des livres les plus importants et des encyclopédies figuraient des index permettant de chercher la page ou l’article utile.

Des catalogues permettaient de faire des recherches dans le contenu des bibliothèques ou dans les fonds des éditeurs.

Yahoo, le pionnier des catalogues

Le plus célèbre de ces catalogues de sites, initié par des étudiants débrouillards portait [2] le joli nom de Yahoo !. L’image ci-dessous représente le site Yahoo en 1996, soit la préhistoire du Web :

Les sites ou pages y étaient classés par des indexeurs humains qui visitaient les sites et les intégraient dans la rubrique appropriée.

Mais très vite, l’explosion du nombre des documents disponibles à rendu ingérable un tel annuaire qui ne reflétait qu’une faible partie du fond documentaire de la toile et dont la mise à jour devenait ruineuse.

Après le catalogue Yahoo apparaissent les index : les moteurs de recherche

Quelques pionniers ont alors l’idée d’automatiser le processus d’indexation : des ordinateurs connectés au réseau et appelés "spiders" vont explorer automatiquement le web en se comportant comme un internaute qui cliquerait au hasard sur tous les liens rencontrés sur les sites.

Chaque page est analysée et les mots contenus dans la page sont stockés dans un gigantesque index. Des requêtes (interrogations) faites ensuite sur cet index permettront de retrouver les sites visités, exactement comme l’index d’une encyclopédie permet de trouver le bon article au sein de 20 gros volumes. Les moteurs de recherche étaient nés : Wanderer, puis Lycos, Excite [3]

Nous sommes toujours dans des processus très classiques : malgré la lecture automatique des pages, les bases de données, les spiders qui remplacent les indexeurs humains, ce n’est jamais que de l’indexation de mots dans un texte comme elle se faisait depuis l’invention des textes imprimés.

Les premiers moteurs de recherche automatisent l’indexation traditionnelle, mais n’inventent rien

Ces moteurs de recherche de première génération tentent de perfectionner leur indexation en apportant plus de poids aux mots répétés dans la même page ou présents dans les titres, les descriptions ou les mots-clés du site. Leur qualité culmine avec AltaVista, roi des moteurs de recherche des années 90. Mais il n’y a toujours aucune réelle nouveauté dans cette approche ; les encyclopédistes réalisaient cela manuellement depuis plusieurs siècles.

Les moteurs atteignent par ailleurs des limites infranchissables :

![]() Il ne peuvent correctement indexer et classer que les pages bien rédigées par leurs auteurs : un titre mal choisi, une page mal organisée, et voila un document de référence qui ne sera proposé qu’en 50ème position dans les résultats de recherche ; autant dire invisible. Contrairement aux encyclopédies dont les rédacteurs travaillent de concert, les webmasters sont libres d’organiser leurs sites et pages comme ils le souhaitent et ils génèrent un chaos bien difficile indexer finement.

Il ne peuvent correctement indexer et classer que les pages bien rédigées par leurs auteurs : un titre mal choisi, une page mal organisée, et voila un document de référence qui ne sera proposé qu’en 50ème position dans les résultats de recherche ; autant dire invisible. Contrairement aux encyclopédies dont les rédacteurs travaillent de concert, les webmasters sont libres d’organiser leurs sites et pages comme ils le souhaitent et ils génèrent un chaos bien difficile indexer finement.

![]() Le commerce apparaît sur la toile, et les marchands ont tôt fait de s’intéresser aux méthodes d’indexation qu’ils manipulent à leur guise : comme les critères de pertinences utilisés par les moteurs sont uniquement [4] liés au contenu de la page, il est facile d’optimiser ou plutôt de truquer ses propres pages pour les faire sortir dans les premiers résultats des moteurs de recherche [5].

Le commerce apparaît sur la toile, et les marchands ont tôt fait de s’intéresser aux méthodes d’indexation qu’ils manipulent à leur guise : comme les critères de pertinences utilisés par les moteurs sont uniquement [4] liés au contenu de la page, il est facile d’optimiser ou plutôt de truquer ses propres pages pour les faire sortir dans les premiers résultats des moteurs de recherche [5].

Nous sommes en 1998, Sergey Brin et Larry Page ont 25 ans, la révolution 2.0 va commencer

Nous sommes arrivés à la limite d’un modèle millénaire de classement de la connaissance (rayons, étagères, annuaires, index, table des matières...) et c’est alors qu’entrent en scène Sergey Brin et Larry Page, deux étudiants en informatique de l’université Standford.

Ils ont 25 ans, nous sommes en 1998, la révolution 2.0 va commencer.

- Cette photo des fondateurs de Google paraît ancienne. Elle n’a pourtant que 6 ans...

Ce qui n’était initialement qu’un simple projet de recherche propose une rupture totale avec le passé : les critères qui permettent d’apprécier la pertinence d’un document ne sont plus tant dans le document lui-même que dans l’usage que d’autres lecteurs ou bibliothécaires en font.

Avant 1998 : on analyse le contenu du document pour le classer et déterminer sa valeur :

![]() avec son cerveau : éditeur d’annuaire, bibliothécaire

avec son cerveau : éditeur d’annuaire, bibliothécaire

![]() ou avec un indexeur automatique : fonctions de certains logiciels (Word), spiders des moteurs de recherche qui parcourent la toile sans relâche et indexent automatiquement son contenu.

ou avec un indexeur automatique : fonctions de certains logiciels (Word), spiders des moteurs de recherche qui parcourent la toile sans relâche et indexent automatiquement son contenu.

Après 1998 : Google analyse le comportement des hommes autour des documents, agrège ces comportements et en tire des informations sur la pertinence d’un document pour une recherche donnée.

Ce sont les connexions créées par des hommes entre les documents qui permettent d’apprécier leur pertinence.|

C’est une rupture totale avec le passé, c’est un des concepts fondateurs du Web 2.0

Avant d’étudier plus en avant le fonctionnement de Google, tordons le cou d’emblée à une idée aussi fausse que répandue : Google n’identifie pas les documents les plus "populaires" au sens des documents les plus souvent consultés. Un tel critère n’aurait aucun intérêt et aboutirait rapidement à un nivellement de la qualité de l’information disponible, chaque éditeur de site cherchant alors à plaire au plus grand nombre. Ce serait "l’effet TF1" sur le Web.

La réflexion de Larry Page et Sergey Brin a été la suivante : chaque fois que quelqu’un écrit une page pour internet, il crée des liens dans cette page pour indiquer au lecteur d’autres pages qui lui paraissent pertinentes, pour approfondir la réflexion sur le sujet traité ou pour étayer ses dires. C’est une graine d’intelligence : ces auteurs utilisent leurs capacités d’analyse et leur connaissance du sujet pour créer ces liens. Si l’on pouvait regrouper ce travail intelligent mais éparpillé en un tout cohérent, il y aurait émergence d’une intelligence collective permettant d’identifier les documents intéressants.

Tel un cerveau dont l’intelligence repose sur des millions de connexions entre ses neurones, les connexions (liens) entre les millions de pages de la toile(autre nom du web) constituent une forme d’intelligence supérieure qu’il serait merveilleux de pouvoir utiliser autrement qu’en cliquant de lien en lien.

Les connexions neuronales de notre cerveau se sont créées au fur et à mesure de nos apprentissages et de nos expériences.

Les liens internet se créent au fur et à mesure de la création des pages. Nous verrons aussi que Google "apprend" en examinant le comportement des lecteurs.

Page et Brin ont alors l’idée de créer une première règle d’indexation pour utiliser au mieux cette intelligence. Cette règle porte le nom de PageRank, du nom de son créateur. Ce sera leur sujet de mémoire de fin d’étude [6]

- Premier serveur Google, fabriqué avec des LEGOs (ce n’est pas une blague).

Le principe initial du PageRank est simple : une page internet est présumée intéressante si d’autres pages font des liens vers elle. Cela peut se traduire facilement dans l’ancienne représentation du classement de l’information : un livre est intéressant s’il remplit les conditions suivantes :

![]() Il est souvent cité en référence par d’autres livres ou articles [7]

Il est souvent cité en référence par d’autres livres ou articles [7]

![]() Il est souvent conseillé par un bibliothécaire.

Il est souvent conseillé par un bibliothécaire.

Notez que le critère "il est souvent lu" n’est pas pris en compte : Si un livre répondant aux deux critères précédents est certes plus souvent lu qu’un autre, il ne sera pas forcément le plus lu. Le nombre de lectures d’un livre ou d’un article n’est pas un facteur de qualité significatif.

Le schéma ci-dessous illustre bien le fonctionnement du PageRank ; la taille du petit personnage qui représente une page internet est proportionnelle à l’importance accordée à son contenu. Cette taille dépend de deux éléments :

![]() Le nombre de liens qui pointent vers lui.

Le nombre de liens qui pointent vers lui.

![]() L’importance (qualité) de ceux qui font des liens vers lui.

L’importance (qualité) de ceux qui font des liens vers lui.

Etre lié (pointé par) un éditeur de site de qualité augmente plus le PageRank qu’être lié par une page anonyme ou peu considérée [8].

Jusque-là c’est simple, mais récapitulons tout de même les grands principes de Google :

![]() Google propose une rupture totale avec l’indexation traditionnelle : ce n’est plus le contenu du document qui est le plus important, mais ce qu’en pensent les autres auteurs et les bibliothécaires.

Google propose une rupture totale avec l’indexation traditionnelle : ce n’est plus le contenu du document qui est le plus important, mais ce qu’en pensent les autres auteurs et les bibliothécaires.

![]() Google ne propose pas les liens les plus populaires, les plus lus, ou les mieux considérés par la foule des internautes car ces données ne sont pas pertinentes.

Google ne propose pas les liens les plus populaires, les plus lus, ou les mieux considérés par la foule des internautes car ces données ne sont pas pertinentes.

![]() Au contraire, Google met en valeur et vous propose les liens conseillés par d’autres auteurs car il considère qu’en faisant cela, il fédère l’intelligence de tous ces auteurs et que cette intelligence collective est plus rapide et étendue que toute autre. Google est un système neuronal qui s’apparente à un metacerveau [9] utilisant chacun des sites et ses liens comme un cerveau humain utilise ses neurones.

Au contraire, Google met en valeur et vous propose les liens conseillés par d’autres auteurs car il considère qu’en faisant cela, il fédère l’intelligence de tous ces auteurs et que cette intelligence collective est plus rapide et étendue que toute autre. Google est un système neuronal qui s’apparente à un metacerveau [9] utilisant chacun des sites et ses liens comme un cerveau humain utilise ses neurones.

Nos deux brillants sujets sont tellement sûrs de leur fait que la page d’accueil de leur nouveau site est une véritable provocation :

Jugez-donc :

![]() aucun décor : un cadre de saisie et un titre, c’est tout. Pas d’options de recherche, de mode "avancé", ils insistent sur la rupture avec Altavista, le leader du marché des moteurs de recherche en 1998 dont la page d’accueil (ci-dessous) était déjà chargée pour l’époque.

aucun décor : un cadre de saisie et un titre, c’est tout. Pas d’options de recherche, de mode "avancé", ils insistent sur la rupture avec Altavista, le leader du marché des moteurs de recherche en 1998 dont la page d’accueil (ci-dessous) était déjà chargée pour l’époque.

![]() un bouton énigmatique "J’ai de la chance" affiche directement à l’écran le premier résultat de la recherche, sans passer par un page intermédiaire de liste de résultats. Dans la majorité des cas, ce premier résultat est le bon ! L’effet de saisissement est garanti alors qu’il fallait auparavant tester plusieurs résultats de recherche, voire plusieurs moteurs pour obtenir péniblement le document ou site recherché.

un bouton énigmatique "J’ai de la chance" affiche directement à l’écran le premier résultat de la recherche, sans passer par un page intermédiaire de liste de résultats. Dans la majorité des cas, ce premier résultat est le bon ! L’effet de saisissement est garanti alors qu’il fallait auparavant tester plusieurs résultats de recherche, voire plusieurs moteurs pour obtenir péniblement le document ou site recherché.

Mais à ses débuts, Google ne "pense pas", il se contente de trier l’information en examinant des liens entrants et en calculant un PageRank pour chaque page, ce qui est une fonction cognitive singulièrement limitée.

Voyons comment il va étendre ses capacités pour devenir la porte d’entrée principale sur le Web et symboliser le Web 2.0

Amélioration du PageRank

Le PageRank n’était qu’une première étape. L’algorithme (la méthode de calcul) qui permet actuellement à Google de trier les ressources du Web repose sur une centaine de critères, sur lesquels le secret est jalousement gardé pour éviter toute manipulation par les éditeurs de sites [10]. Certains de ces critères sont néanmoins suspectés ou connus et l’on se rapproche de plus en plus d’un fonctionnement neuronal :

- Réseau de neurones en 3D

Le PageRank s’appuie non plus sur les éditeurs quelconques qui font un lien vers une page, mais sur les éditeurs qui traitent du même sujet. C’est une modification importante car elle augmente la qualité de la sélection. Ce ne sont plus les bibliothécaires ou les auteurs en général qui conseillent un ouvrage ou un article, mais d’autres spécialistes du sujet traité. Ces "spécialistes" peuvent être réels ou autoproclamés, mais la loi du nombre pondère les extrêmes.

Les liens sortants sont pris en compte. Il ne faut pas seulement être conseillé par d’autres auteurs (liens entrants), il faut soi-même conseiller de bons documents pour accroître sa réputation, ce qui est assez logique et conforme à ce qui se passe dans la vie réelle.

Google propose différents services additionnels, dont une barre d’outils qui permet à son utilisateur de stocker ses adresses de sites (favoris). La base de données est stockée sur les serveurs de Google. Il est probable que le moteur tient compte des sites sélectionnés pour leur donner un poids plus important. De plus, les internautes créent des dossiers pour ranger ces liens et le nom de ces dossiers est une informations très importante [11]

Google n’analyse plus seulement le nombre de liens qui pointent vers un site, mais la dynamique d’apparition de ces liens. En effet, des liens artificiels créés pour l’influencer apparaissent généralement tous en même temps et à partir du même site. Au contraire, un contenu de qualité génère des liens spontanés dont la répartition dans le temps est progressive et étalée sur de nombreux sites.

Google tient compte de l’âge du document et de sa mise à jour. Un contenu ancien inséré dans un site qui ne bouge plus risque d’être moins pertinent qu’un article souvent modifié ou intégré dans un site dynamique.

Lorsque vous faites une recherche dans Google, celui-ci analyse votre comportement sur la page de résultat. Si vous allez voir une page indiquée et que vous revenez après quelques secondes, c’est que cette page ne correspondait pas à votre attente. Son PageRank sera abaissé. Au contraire, la page consultée en dernier aura un PageRank augmenté : si vous avez cessé vos recherches après cette page, c’est sans doute parce qu’elle a répondu à votre attente.

Et il existe des dizaines d’autres critères destinés à reconnaître la bonne information sans la moindre analyse du contenu. Ces règles fonctionnent aussi bien pour du français que de l’anglais ou du chinois. Google met en oeuvre des techniques de détection de la fraude si pointue que le principal conseil actuellement pour être bien classé dans le moteur est "créez des contenus intéressants". Peut-on imaginer meilleure consécration pour le moteur ?

Google ne peut trouver que ce qui existe

Bien sûr, tout n’est pas parfait et le moteur vedette est parfois à la peine sur certaines requêtes difficiles [12] ou très commerciales. Il faut néanmoins avoir a l’esprit une contrainte importante : Google comme tous les moteurs, ne peut trouver que ce qui est accessible. Autant le Web est riche en langue anglaise, autant le monde francophone tarde à libérer ses contenus. L’absence de lien de qualité dans une requête ne fait souvent que refléter (dans le monde francophone) la pauvreté des contenus en accès libre disponibles.

En corollaire, sachant que Google est la porte d’entrée sur Internet pour la grande majorité des internautes, tout document qui n’est pas indexé par Google "n’existe pas", mais ceci une autre histoire.

Nous venons de passer en revue la façon dont Google s’appuie sur le travail intellectuel des webmasters et sur le comportement des internautes pour agréger ce "jus de cervelle virtuel" en une forme d’intelligence neuronale. C’est à mon avis un des plus bel exemple du Web 2.0 :

![]() Google ne demande d’effort à personne, il utilise un travail déjà réalisé par d’autres pour d’autres objectifs.

Google ne demande d’effort à personne, il utilise un travail déjà réalisé par d’autres pour d’autres objectifs.

![]() Google met en forme des données publiques, mais que lui seul parvient à agréger correctement.

Google met en forme des données publiques, mais que lui seul parvient à agréger correctement.

![]() Google est ouvert à tous et ne coûte rien à ceux qui utilisent ses services, tout en gagnant énormément d’argent avec d’autres (le Web 2.0 n’est en rien synonyme de bénévolat).

Google est ouvert à tous et ne coûte rien à ceux qui utilisent ses services, tout en gagnant énormément d’argent avec d’autres (le Web 2.0 n’est en rien synonyme de bénévolat).

![]() Google sépare clairement le service qu’il apporte (trouver l’information) et son gagne-pain (la publicité). S’il ne le faisait pas, il disparaîtrait en quelques années faute d’utilisateurs, tant la crédibilité de ses résultats serait altérée.

Google sépare clairement le service qu’il apporte (trouver l’information) et son gagne-pain (la publicité). S’il ne le faisait pas, il disparaîtrait en quelques années faute d’utilisateurs, tant la crédibilité de ses résultats serait altérée.

![]() Google touche à un domaine clé de la civilisation de l’information : l’accès à la bonne information au sein d’un "bruit" phénoménal.

Google touche à un domaine clé de la civilisation de l’information : l’accès à la bonne information au sein d’un "bruit" phénoménal.

![]() Google se fonde sur un réseau, mot-clé du Web 2.0 mais il ne le crée pas : il utilise le réseau constitué par les auteurs-lecteurs du Web.

Google se fonde sur un réseau, mot-clé du Web 2.0 mais il ne le crée pas : il utilise le réseau constitué par les auteurs-lecteurs du Web.

![]() Google est un outil conçu par des gens supérieurement intelligents qui ne se prennent pas au sérieux, j’aime bien la photo ci-dessous.

Google est un outil conçu par des gens supérieurement intelligents qui ne se prennent pas au sérieux, j’aime bien la photo ci-dessous.

Et pour conclure en riant ou en pleurant, le Web 2.0 est ce qui nous permettra d’échapper à ceci : La folle histoire de l’échec annoncé et réussi du Dossier Médical Personnel ou comment des gens supérieurement incompétents qui se prennent très au sérieux ont réussi à dépenser beaucoup d’argent qui n’était pas à eux en prétendant faire des économies.

Heureusement pour eux, la révolution 2.0 ne décapite pas les dinosaures, elle se contente de les rendre obsolètes.

Si la transition [13] Web 2.0 appliqué à la médecine vous intéresse, je vous suggère le lire les autres articles de cette rubrique.

[2] Cet annuaire existe toujours, mais il a disparu de la page d’accueil du site Yahoo, car il n’est plus guère utilisé : Google lui a enlevé quasiment tout intérêt.

[3] Tous ces moteurs ont disparu ou ont été remplacés par d’autres services

[4] Pour être honnête, il faut reconnaître que quelques critères extérieur sont aussi pris en compte dans les dernères versions des moteurs 1.0, notamment le fait que le site contenant la page ait été indexé dans des annuaires gérés manuellement comme Yahoo

[5] Ces techniques d’optimisation portent désormais le nom de "référencement" et son devenues un métier à part entière

[6] Pour simplifier la compréhension du fonctionnement de Google, je ne tiens pas compte de l’évolution progressive des algorithmes au cours du temps et je décris un fonctionnement global actuel

[7] Principe proche du "facteur d’impact" utilisé avec les publications sur papier et né quelques années avant le PageRank

[8] Les plus attentifs d’entre vous ont remarqué la similitude avec l’histoire de la poule et de l’oeuf ! Comment commencer ? Quels sont les premiers sites de qualité ?

Ce problème a été géré par l’identification initiale de sites présents dans les annuaires (et donc déjà sélectionnés par un cerveau humain) et par ce qu’on appelle la récursivité(désolé pour ce gros mot) : tous les mois, Google analyse les liens entre les sites de son index pendant une courte période joliment appelée "Google Dance" et modifie le PageRank de chaque site en fonction notamment de ses liens entrants (qui pointent vers lui). Cette remise à niveau permanente du PageRank permet un ajustement de la place de chaque site ou page dans les résultats du moteur de recherche en fonction de la progression (ou baisse) de sa réputation.

[9] Pour ceux qui n’ont pas peur de rêver, lire cet essai sur l’hyperscience

[10] On peut assimiler le passage des spiders de Google sur les sites à un examen ; pour qu’un examen soit juste, il vaut mieux que le sujet n’en soit pas connu à l’avance

[11] Ce concept sera développé dans un article qui traitera spécifiquement de cette classification libre appelée Folksonomie

[12] C’est sur les concepts fumeux ou ésotériques que Google est le plus fragile car il va mettre en valeur non pas le site le plus scientifique, mais parfois le site le plus représentatif de cette théorie ou de ce mouvement, surtout si aucune page de fait un point sérieux sur le sujet

[13] J’emploie volontiers le terme de transition 2.0 plutôt que révolution, car il s’agit d’un mouvement non violent, qui ne s’oppose à rien ni personne, mais crée de novo des choses utiles : réseaux, documents, services. Il est significatif de noter que la majorité des services 2.0 sont nés à côté et non à l’intérieur des sociétés leaders sur leurs marchés.

Version imprimable

Version imprimable

Messages

9 avril 2015, 13:56, par malika

Où l’idée quand même que l’enthousiasme de la jeunesse et la "pureté" de l’intention ( offrir une source de savoir encyclopédique facile a tout le monde) résiste assez rarement au succès économique et aux intérêts qui en découlent.

Je suis un professionnel de la santé à l’étranger http://www.medespoir.com et je mesure chaque jour le prix qu’il faut débourser pour être visible sur Google quand il est nécessaire de recourir aux liens sponsorisés pour exister.

Adwords , c’est la machine à cash du géant et ses services annexes comme le knowledge graph sont a mon avis des bonbons pour faire passer la pilule et nous faire croire que le projet d’une mathesis universalis est toujours dans la tête des fondateurs.

7 septembre 2021, 02:42, par Mon grain de sel

Dans les années 80/90, il y a eu une dizaines de petites sociétés françaises qui voulaient faire du "gougueule" avant Gogoogle., en se basant sur le projet français des Systèmes Experts (Prolog), aujourd’hui disparu.

Aucune n’a abouti car les banques étaient réfractaires au financement des projets qu’ils disaient "irrationnels".

Un ingénieur racontait que sa banquière était super étonnée que le glossaire des erreurs du projet les mentionnait en "français" et non en "anglais", ce qui aurait été plus "professionnel" ; (pour elle, l’informatique ne pouvait être qu’en anglais)

Idem pour le langage LISP dédié à l’I.A.

Tout comme l’O.S. français "Memsoft" qui a existé bien avant l’O.S. "Microsoft".

Certaines de ces sociétés sont parties s’installer aux USA, d’autres au Canada ou en Australie.

Comme toujours, les français ont les idées mais pas d’argent.